L’importanza di filmare tutto

Senza le testimonianze collettive ci manca un pezzo fondamentale per smascherare le narrazioni del potere.

Una proof of concept di un universo narrativo per ragazze e ragazzi

Mi è venuta un’idea per un universo narrativo per ragazze e ragazzi – quello che in gergo si chiama intellectual property.

L’idea mi è venuta dopo una serie di esperimenti fatti con un oggetto che si chiama rabbit R1.

Ma come presentarla? Quel che mi serve è una proof of concept nella speranza di attirare l’attenzione in maniera rapida.

Qual è il modo più rapido? Probabilmente un video. Ma come farlo?

Ho pensato di condividere il mio approccio, nella speranza che possa essere utile per chi vuole fare percorsi simili (e anche per scambiare idee, più in generale).

Il rabbit R1 ha una fotocamera incorporata. La fotocamera utilizza un’intelligenza artificiale image-to-image – cioè: riceve in ingresso un’immagine, offre in uscita un’altra immagine. Di fatto, è come avere una fotocamera modifica la realtà. Nella sua versione originale, l’ia del rabbit R1 trasformava le foto scattate con un’estetica a 8 o 16 bit, come le vecchie immagini dei computer.

Negli aggiornamenti successivi, la macchina fotografica del rabbit R1 è diventata multimodale. Cioè: puoi fotografare qualcosa e aggiungere un comando vocale, chiedendo di modificare quel qualcosa secondo un certo stile o trasformandolo in qualcos’altro.

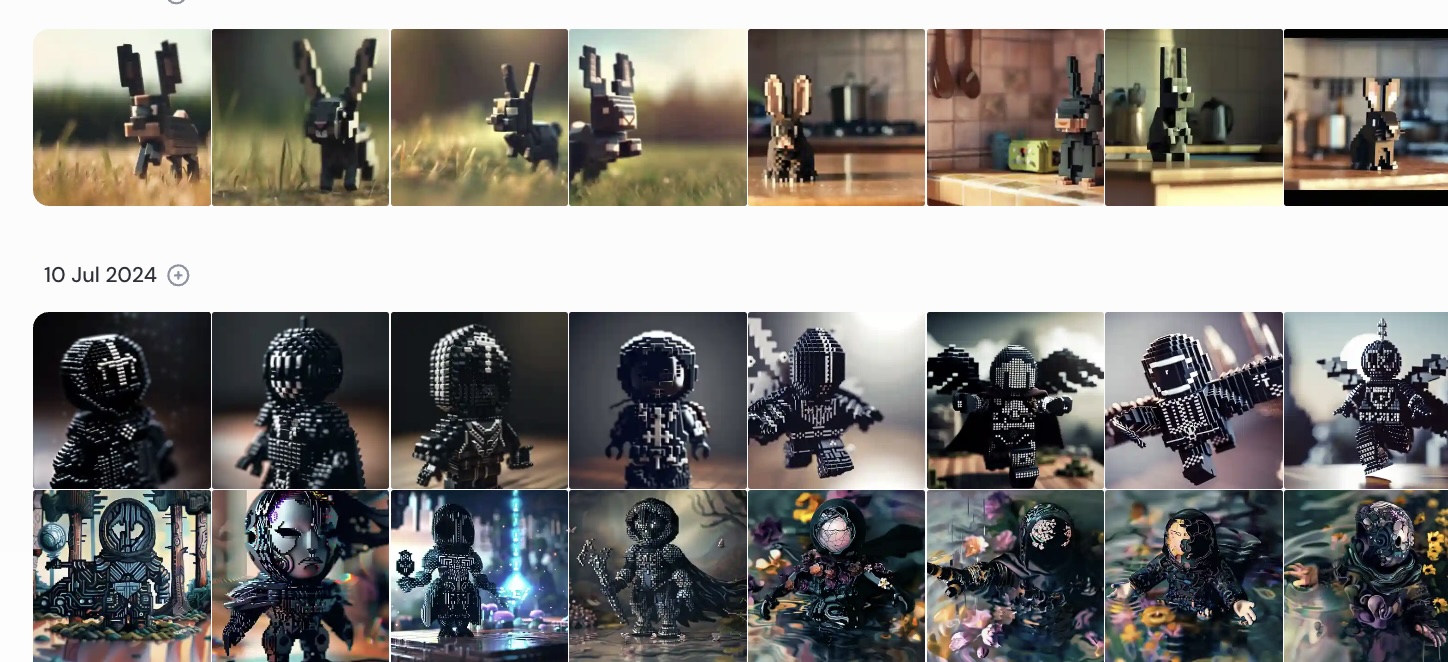

Ho scritto per Slow News un reportage di viaggio illustrandolo con le foto trasformate sul rabbit e ho continuato a sperimentare. Ad un certo punto mi sono accorto che, fotografando alcuni oggetti specifici – per esempio, dei pupazzetti – l’ia del rabbit smetteva di fare le immagini a 8 o 16 bit e faceva dei render iper-realistici. Gli oggetti fotografati mantenevano la caratteristica estetica “a pixel”, ma come se fossero in tre dimensioni.

A furia di fare esperimenti con pupazzetti e sfondi vari, il rabbit ad un certo punto ha generato questi due personaggi che vedi: un giocattolo cavaliere e il suo coniglio.

Sì, perché come watermark il rabbit aggiunge – quasi sempre – un coniglio nascosto da qualche parte nell’immagine.

Appena li ho visti ho deciso che dovevano essere personaggi di una storia. L’immagine era quadrata, l’ho espansa in 16:9 con Canva.

Poi l’ho caricata su ChatGPT – il modello di intelligenza artificiale della OpenAI – e ho chiesto alla macchina di fare con me brainstorming per trovare un nome a questi due personaggi.

Alla fine ho scelto Nox per il giocattolo umanoide e Polvere per il coniglio (Nox & Dust suona bene anche in inglese e alla fine ho tenuto Dust).

Ho scritto qualche riga di biografia per i due personaggi: sono evidentemente giocattoli viventi. Nox è femmina, senza paura, introspettiva, alla ricerca di sé e del proprio posto nel mondo. Dust è maschio, più scanzonato e basico, ama Nox e farebbe di tutto per lei. Ho deciso che a Dust sarà affidata la parte “comedy” delle storie che svilupperò. Ho cominciato a immaginare i temi da trattare, la ragazza e il bambino che abitano la stessa stanza in cui Nox e Dust hanno preso vita, l’estetica della storia.

Prese queste decisioni, volevo dedicarmi a produrre diverse immagini render. Come sappiamo le intelligenze artificiali generative rimangono probabilistiche ed è molto difficile ottenere adesione al modello di partenza. Tuttavia, sapevo che se avessi voluto provare a realizzare da me una Nox e un Dust mi sarebbe costato talmente tanto tempo o talmente tanti soldi (o entrambi) che, semplicemente, mi sarei scoraggiato.

Volevo altre immagini, dicevo.

Ho preso l’immagine originale espansa e l’ho messa su Midjourney – un’ia text-to-image, che utilizza anche immagini come riferimento per generarne altre – per provare a ottenere una serie di inquadrature diverse di Nox e Dust.

Mi sono scontrato con un’evidenza: se le intelligenze artificiali che generano immagini cominciano a mantenere la coerenza estetica di forme umane, fanno molta più fatica con quel che non è umano. Così, mi sono trovato di fronte a una serie di inquadrature di Nox (soprattutto) e di Dust molto diversi fra loro. Questo è un grosso limite, che rischiava di farmi arenare.

Pensandoci un po’, mi sono detto: ok, ma se Nox è così introspettiva, alla ricerca di sé, se non riesco a farle mantenere la sua forma, perché non decidere che è un personaggio mutaforme? In fondo è coerente con tutto: con l’estetica “pixellata” e a mattoncini, con l’idea che possa aver preso vita in una stanza piena di altri giocattoli.

Magari Nox assorbe qualche pezzetto di altri giocattoli nella sua essenza. Non nel senso che si trasforma in un t-rex o altro: mantiene una coerenza strutturale, ma diventa più o meno dark, con le ali o con la spada; diventa un’automobilina o un elicottero-giocattolo se deve spostarsi.

Sì, è così: Nox è una mutaforme!

Se mai dovessi fare del merchandising, mi sono detto, ecco che potrei fare delle Nox e dei Dust collezionabili. Mi piace, come idea.

A questo punto mi importava poco che Midjourney perdesse la coerenza del personaggio e ho cominciato a generare tante versioni di Nox con comandi diversi per farmi ispirare e fare ricerca a proposito delle tematiche da trattare.

Mi sono fatto una lista di appunti sui temi che vanno affrontati nelle varie storie. Ho descritto l’universo narrativo a ChatGPT e ho chiesto alla macchina di fare insieme brainstorming.

Ora, io lo so quanto è complicato presentare un’idea a chi potrebbe produrla. Ci lamentiamo tanto del tempo di attenzione delle persone là fuori, ma spesso la mancanza di attenzione è un problema che sta dentro la medesima “industria culturale”. Così mi sono detto: Nox e Polvere sono belli. Devo provare a fare un trailer video che funzioni da pitch.

Così ho scritto il trailer per come doveva essere secondo me.

Ho usato Midjourney per fare diversi tagli di inquadrature e per aggiungere personaggi che mi servivano, cercando di mantenere per quanto possibile un minimo di coerenza estetica.

Ho usato Elevenlabs per generare le voci di Nox e Polvere.

Ho scritto le varie scene del trailer (movimenti di macchina e azioni, sfondi e via dicendo). Ho chiesto a ChatGPT di trasformare le mie descrizioni di scena in prompt per Runway – un’intelligenza artificiale text-to-video e image-to-video) e poi ho usato Runway per generare le varie scene (spesso incrociando le dita perché, soprattutto all’inizio, il controllo che si ha con quel che combina Runway è molto basso).

Infine, ho generato una musica da viaggio epico-introspettivo con Suno.

Ho creato i rumori che mi servivano con Elevenlabs.

Poi mi sono messo a montare il tutto con Premiere Pro.

Ecco il risultato.

Sono molto consapevole del processo e di quel che ho fatto; so quali sono i difetti del trailer, le cose brutte, quelle che non funzionano: l’ho montato appositamente in modo da nasconderne i difetti principali e ho cercato a ogni passo di aggirare i paletti o addirittura di usare quei paletti a scopo creativo. E so benissimo che, in questo momento, non posso nemmeno realizzare un cortometraggio tradizionale con Nox e Polvere. So anche che non voglio né vorrei mai farlo da solo con le macchine: vorrei farlo con altre umane e altri umani e altre macchine, perché penso che il processo creativo sia collettivo, che Nox e Polvere possano diventare un bellissimo percorso da fare con persone con cui condivido una certa visione della vita.

Nel frattempo, però, Nox e Polvere sono già finiti su RaiUno a Codice, in un intervento in cui ho raccontato come uso le intelligenze artificiali generative.

Ora ho un trailer che non avrei mai potuto fare da zero se non con costi e tempi inauditi, che fa vedere cosa sono e cosa possono essere Nox e Polvere. Già che ci sono, ho un racconto di un un processo di integrazione delle intelligenze artificiali nel lavoro che, se vuoi, posso anche insegnarti (sì, perché fra le altre cose per campare faccio anche formazione sulle intelligenze artificiali).

? Umani:

Ideazione, regia, montaggio, prompt: Alberto Puliafito

Aiuto regia: Alessandro Puliafito

Sperimentatori con AI: Alessandro Puliafito, Gaia Puliafito

Consulente di produzione: Fulvio Nebbia

Un ringraziamento speciale a: Anna Castiglioni, Adriano Barone

? Intelligenze artificiali

Immagine di partenza: fatta con il Rabbit R1

Storyboard e immagini statiche: fatti con Midjourney

Voci di Nox e Dust: fatte con Elevenlabs

Video: fatti con Runway

Colonna sonora: fatta con Suno

Effetti audio: fatti con Elevenlabs

Assistente per i prompt: ChatGPT

?️ Altri strumenti utilizzati: Adobe Premiere, Canva, Google Docs

Senza le testimonianze collettive ci manca un pezzo fondamentale per smascherare le narrazioni del potere.

Il brutto e l’appiattimento sono umani.

Una giornata, a partecipazione gratuita, per parlare di come informiamo e di come ci informiamo nell’era delle intelligenze artificiali generative.

Domande e risposte sul destino della lotta di classe ai tempi delle I.A.